Modernizace našeho prvního datacentra “Bunkr” začala minulý rok v říjnu. Jednalo se o dlouho plánovaný projekt postavený na nově získaných zkušenostech se stavbou DC2 a hlavně s aktuálně probíhající certifikací TIER IV. Museli jsme začít přemýšlet úplně jinak, najít nové technologie a také se přizpůsobit technologickým trendům současnosti a blízké budoucnosti.

Jak jsme přestavěli datový sál v DC1

Pokud jste u nás někdy byli na exkurzi, tak jste mohli vidět úhledný datový sál s racky, dominantním Freecoolingem a dalšími technologiemi po stranách. Prostě takový běžný datový sál.

Takto vypadal v roce 2015.

V roce 2017 jsme přikoupili další racky od HPE a protáhli uličku.

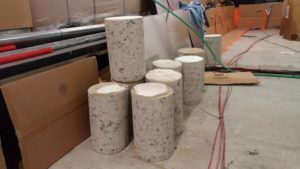

V roce 2018 pak začala modernizace. V budově proběhly rozsáhlé vrtací práce, aby se vše připravilo na rozšíření stávajících technologií. Všude přibyly velké díry na tažení kabelů, částí freecoolingu, klimatizací a objevily se nové dveře, jiné zase byly zazděné. Vnitřní, vnější i venkovní část se změnila.

Freecooling

A mohli jsme se pustit do přestavby freecoolingu, který je nejen ekologický, ale hlavně nám pořádně snižuje náklady na provoz. Servery produkují velké množství tepla a uchladit vše klimatizacemi je dnes už velmi drahé. Zvyšování cen elektřiny pak může mít vliv i na cenu služeb.

Naproti tomu freecooling chladí buď úplně anebo jen částečně teplem zvenku. Náš Freecooling jsme si postavili sami. Součástky nakoupili od lokálních výrobců. Takže jej moc dobře známe. Na základě nashromážděných dat a zkušeností z minulých let jsme se rozhodli jej vylepšit.

Takže původní verze z roku 2015:

Byla v březnu 2019 rozšířena následovně:

V dubnu 2019 pak v toto obří monstrum:

Celá technologie je pak oddělena od serverů ohnivzdornou stěnou. Požární odolnost našeho prvního datacentra je celá řešena na 30 minut. Druhé datacentrum je o krok dále a je budované s odolností na 90 minut!!!

Zároveň se celý Freecooling protáhl do další místnosti, kde jsme dříve měli laboratoř na testování olejového chlazení. Tu jsme museli kompletně zrušit. Další testy už budou probíhat v druhém datacentru.

Moc prostoru nám tam nezbývá co :)? Nám to takto vyhovuje, i když datový sál vypadá jako vnitřek kosmické lodi. WEDOS DC1 “Bunkr” je naše soukromé datacentrum určené jen pro naše služby. Víme, kde co máme a jak co funguje.

Ještě jedna zajímavost. Freecooling je jako velký ventilátor, který může tlačit obrovské množství vzduchu. Využíváme princip teplé a studené uličky – studený vzduch je tlačen pod podlahou k serverům do studené uličky odkud si jej servery nasají a vypustí zadem do teplé uličky. Pomocí Freecoolingu jsme schopni v případě potřeby poslat do studené uličky obrovské množství vzduchu pod tlakem (až 70.000 m3 za hodinu).

Tohoto jsme využili, když jsme u jedné komponenty serveru objevili lokální přehřívání součástek. Ventilátory na serveru u určité nízké teploty snižovaly otáčky, i když se komponenta přehřívala. Server měl pocit, že je mu chladno a tedy dobře, a tak si ubral otáčky ventilátoru a tím některé komponenty uvnitř serveru měly problém. Než to vyřešil výrobce aktualizací firmware, tak jsme prostě do serverů tlačili takové množství vzduchu, že se komponenta uchladila i při aktuální teplotě.

I kvůli tomu jsme velkými příznivci Freecoolingu.

Elektřina

Minulý rok jsme také připojili naší novou trafostanici ze severu. Naše datacentrum DC1 má ještě napájení z jižní strany, kde máme kabely natažené do trafostanice společnosti e.ON.

A přidali dva nové motorgenerátory pro případ dlouhodobého výpadku.

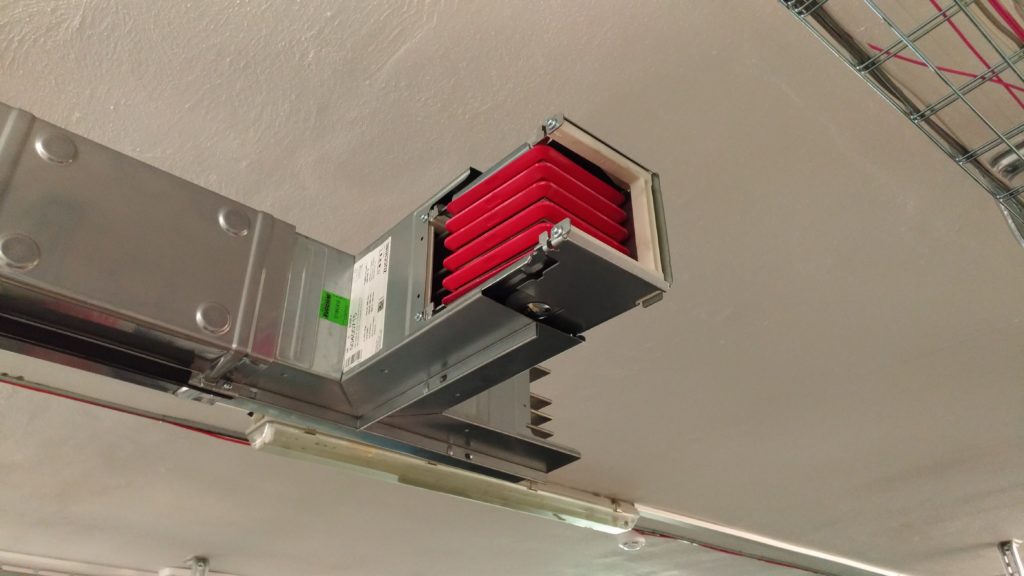

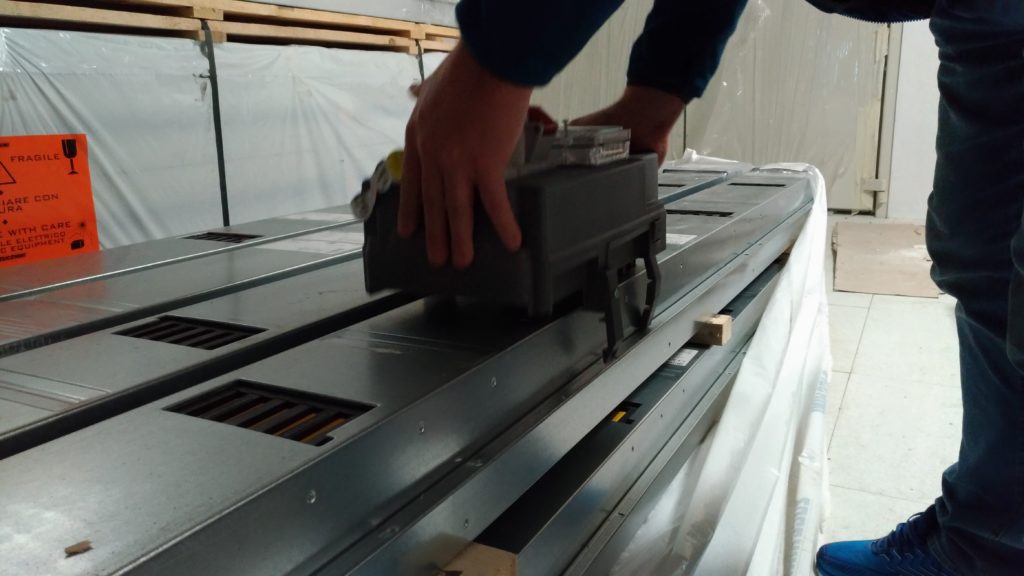

Zároveň začala přestavba první větve elektřiny (pod stropem). Její součástí je nahrazení klasických elektrických kabelů v serverovně přípojnicovým systémem. Stejné řešení přidáme letos pod podlahu a stejné řešení máme již v druhém datacentru DC2.

Jen pro zajímavost. Ačkoliv by bylo levnější a jednodušší vést obě trasy elektřiny naráz pod stropem anebo pod podlahou, rozhodli jsme se postupovat podle TIER IV a mít jednu větev pod stropem a druhou pod podlahou. TIER IV to tak přímo vyžaduje. Z dlouholetých zkušeností víme že to má něco do sebe a vyplatí se do toho investovat.

Přípojnicový systém je stavěný na 800 A pod stropem a na 800 A pod podlahou. Požární odolnost přípojnicového systému je minimálně 120 minut.

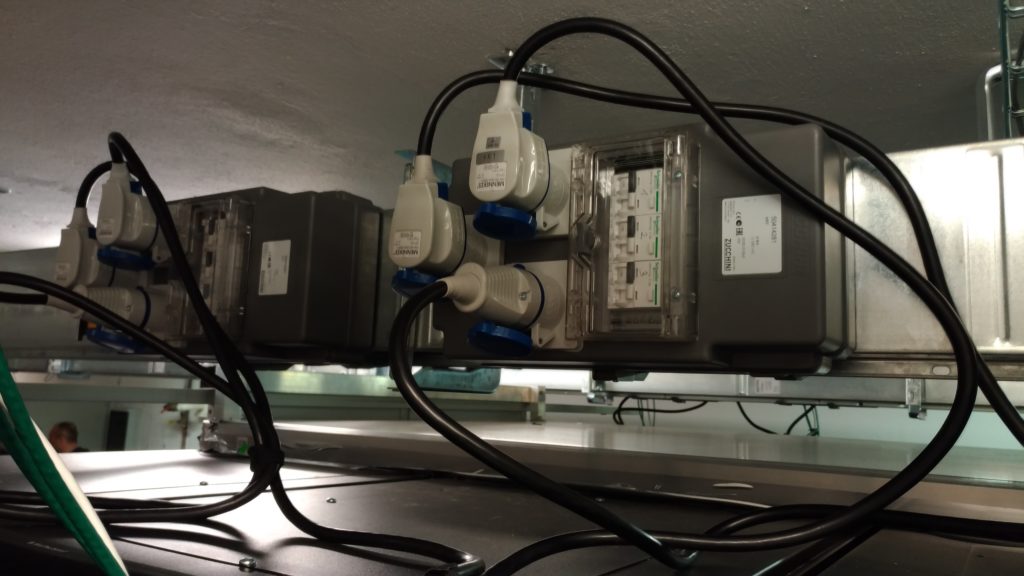

Všechny elektrické kabely jsou také postupně vyměňovány za nehořlavé (hnědé). Opět inspirace TIER IV 🙂

Nehořlavé, samozhášecí kabely, které neprodukují zplodiny, jsou mnohonásobně dražší, než klasické. Cca 5x dražší.

Na obrázku vidíte, že kabelů je tam poměrně hodně. Vycházíme totiž z toho, že vše je projektované až na provozní teploty 40 stupňů Celsia kdekoliv v budově. Proto je tam vždy o něco málo kabelů více…, než by bylo klasicky a než najdete v běžný datacentrech. Opět inspirace TIER IV.

Moc takových instalací v českých datacentrech nenajdete. Jsou to obrovské náklady…

A to na obrázcích vidíte jen jednu část, jedné větvě. Další rozvody jsou v v budově.

Příště ukážeme ještě rozvaděče elektřiny, abyste viděli, jak to vypadá…

Konektivita

Postupně navyšujeme konektivitu jak do počtu tak i rychlosti. Naposledy jsme přidali 100 Gbps do Cogentu. V současné době je DC1 připojeno:

Fyzické Trasy:

- R2 (Cetin) 100 Gbps na SITEL (CeColo)

- R2 (Cetin) 100 Gbps na SITEL (CeColo) jinou trasou

- R1 (CDT) 100 Gbps na žižkovskou věž ČRa

A připojení nyní máme:

- Cogent 100 Gbps (spuštěna v dubnu 2019)

- Kaora 100 Gbps na Sitelu

- Kaora 100 Gbps na Žižkovské věži

- Telia 100 Gbps přes port Kaory

- Telia 10 Gbps přímo

- ČDT 10 Gbps

Nyní máme rozjednané další 2 dodavatele.

Vše je opravdu nadstandardně naddimenzované. Jednak z důvodu, abychom mohli k některým současným (Dedikované servery) a budoucím (WEDOS Cloud) službám nabízet 1 Gbps, ale také abychom mohli lépe odolávat vzrůstajícímu počtu a síle DDoS útoků. Objevují se nové anebo vylepšené formy a ty je nutné pustit si k nám, abychom je mohli lépe analyzovat.

Tento rok měl největší zaznamenaný útok 37 Gbps a směřoval na VPS jednoho našeho zákazníka . Před nasazením 100 Gbps konektivity bychom tento druh útoku museli řešit jinak a obtížněji. Rozhodně bychom jej však nemohli filtrovat.

Další vylepšení

Součástí modernizace jsou samozřejmě i další vylepšení. Nepočítáme-li do toho hardware, tak máme například na zakázku vyrobené rozvodné skříně, nové baterky či spíše kompletní baterkárnu. Místnosti jsou rozdělené podle účelu a protipožárně oddělené anebo jsme třeba do kanceláří dali nové UPS. Ale o tom si napíšeme zase příště.

Vylepšení je opravdu velké množství a stále se jedná o první část modernizace. V další pak budou předělány druhé větve. Časově to zatím moc nestíháme, protože zároveň je nutné dokončit druhé datacentrum. Spousta práce odvádí naši správci datacentra, kteří například táhnout elektrické kabely. Musí ale mít kompletní přehled o každé stavební práci. Máme rádi všechno pod kontrolou, abychom když se něco stalo, věděli přesně co se stalo a kde.

Postupně napíšeme další články o současném datacentru a i nově budovaném.